ATTENZIONE

Questo articolo contiene link vecchi o non più raggiungibili. Per completezza dell'articolo, tali link rimandano (quando possibile) alle versioni più recenti presenti nell'archivio storico di internet (Wayback Machine). Verificare sempre la correttezza di tali informazioni, in quanto datate, e non introdurre mai dati personali in eventuali moduli presenti nelle pagine archiviate.

Tuttavia i suoi creatori non capiscono come ci riesca.

Per la prima volta, gli astrofisici hanno usato tecniche di intelligenza artificiale (AI) per generare complesse simulazioni 3D dell’universo. I risultati sono stati talmente veloci ed accurati che neppure gli stessi creatori sono certi di come il tutto abbia funzionato.

«Possiamo eseguire queste simulazioni in pochi millisecondi, quando altre simulazioni “veloci” richiederebbero un paio di minuti – afferma Shirley Ho, co-autrice dello studio, a capo del team al Centro di Astrofisica Computazionale del Flatiron Institute a New York City, e professore aggiunto alla Carnegie Mellon University – Non solo, riusciamo ad essere anche molto più precisi».

Quello che però ha stupito veramente i ricercatori non sono stati velocità ed accuratezza del progetto, chiamato Deep Density Displacement Model (D3M), ma la sua capacità di simulare accuratamente come sarebbe l’universo se certi parametri venissero modificati (ad esempio la quantità di cosmo composto da materia oscura) nonostante il modello non abbia mai ricevuto alcun dato campione (detto dato di training o addestramento) dove quei parametri fossero variati.

«È come se addestrassimo un software di riconoscimento di immagini con tante immagini di cani e gatti, e nonostante ciò fosse in grado di riconoscere anche gli elefanti – ha spiegato Ho – Nessuno capisce come ci riesca, ed è un grande mistero da risolvere.»

Ho e colleghi hanno presentato D3M il 24 di giugno durante la Cerimonia della Accademia Nazionale delle Scienze. Lo studio è stato diretto da Siyu He, ricercatore analista al Flatiron Institute.

Ho e He hanno lavorato in collaborazione con Yin Li del Centro di Fisica Cosmologica di Berkley all’Università della California e del Istituto Kavli per la Fisica e Matematica dell’Universo vicino Tokyo, Yu Feng del Centro di Fisica Cosmologica di Berkely, Wei Chen del Flatiron Institute, Siamak Ravanbakhsh dell’Università della British Columbia a Vancouver, e Barnabás Póczos della Carnegie Mellon University.

Le simulazioni al computer come quelle realizzate da D3M sono diventate essenziali per gli astrofisici teorici. Gli scienziati vogliono sapere come il cosmo potrebbe evolversi sotto certi condizioni, ad esempio come l’universo ci apparirebbe nel tempo se l’energia oscura lo facesse contrarre. Questo tipo di studi richiede l’esecuzione di migliaia di simulazioni, e la realizzazione di un modello computazionale veloce e altamente accurato è uno dei principali obiettivi dei moderni astrofisici.

D3M simula come la gravità modelli l’universo. I ricercatori hanno optato per la sola gravità perché è la più importante forza che si può rilevare quando si prende in considerazione l’evoluzione del cosmo su larga scala.

Le simulazioni dell’universo più accurate calcolano il modo in cui la gravità sposta ciascuno dei miliardi di singole particelle durante l’intera evoluzione dell’universo. Questo livello di accuratezza necessita tempo, e richiede circa 300 ore di calcolo per ogni simulazione. Metodi più veloci permettono di terminare la stessa simulazione in circa due minuti, ma questo riduce l’accuratezza dei risultati.

Ho, He e colleghi hanno affinato la deep neural network che alimenta D3M dandole in pasto 8000 differenti simulazioni da uno dei modelli con la più alta accuratezza disponibile. Le reti neurali prendono i dati di addestramento (training) ed eseguono calcoli su quelle informazioni, i ricercatori quindi confrontano i risultati ottenuti con quelli che ci si aspetterebbe. Maggiore è l’addestramento, più veloci ed accurate le reti neurali divengono nel tempo.

Una parentesi tecnica. I ricercatori hanno usato una GPU NVIDIA Tesla V100 abbinata ad un framework PyTorch per il deep learning accelerato per cuDNN, durante il primo addestramento, riducendo il tempo di generazione di 1000 simulazioni da 115 a 20 secondi. Per chi fosse interessato, i ricercatori hanno messo a disposizione in rete tutti i dati ed il codice sorgente utilizzati per il loro modello di IA.

Dopo l’addestramento di D3M i ricercatori hanno eseguito delle simulazioni di un universo a forma cubica di 600 milioni di anni luce ed hanno confrontato i risultati con quelli dei modelli lenti e veloci. Dove il modello lento ma accurato ha richiesto centinaia di ore di tempo di calcolo per simulazione e l’esistente metodo veloce ha richiesto un paio di minuti, D3M ha completato una simulazione in appena 30 millisecondi.

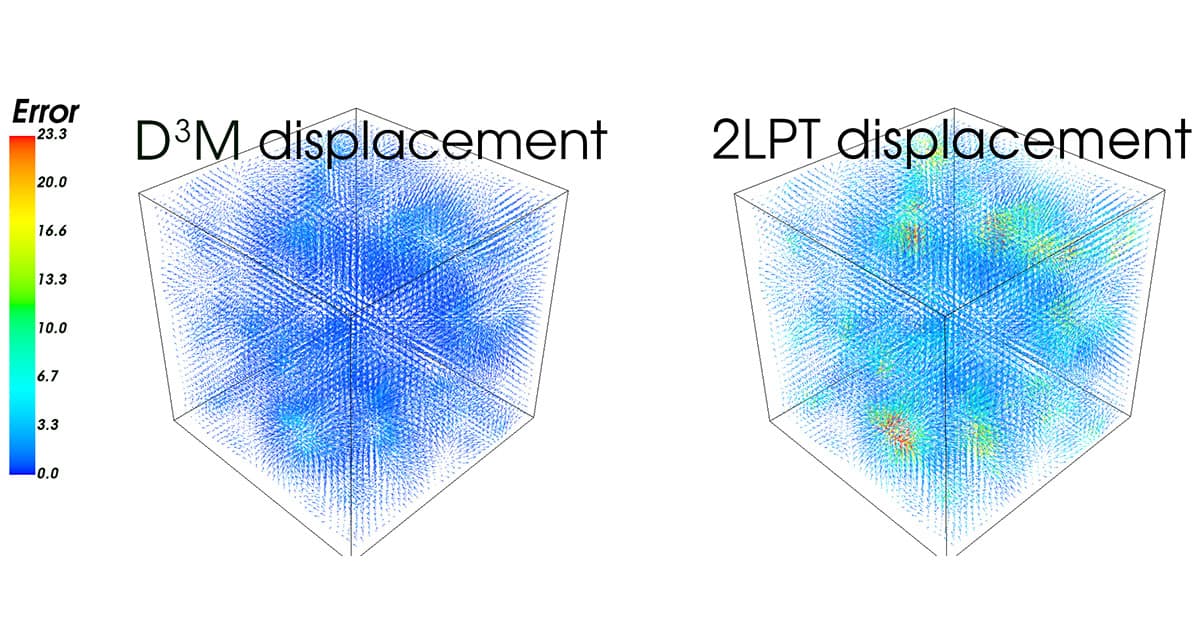

D3M ha anche fornito risultati accurati. Il confronto con il modello altamente accurato ha mostrato come D3M abbia avuto una percentuale di errore relativo pari a 2.8. Usando la stessa comparazione, i modelli esistenti hanno mostrato una percentuale pari a 9.3.

La notevole capacità di D3M nel gestire variazioni di parametri estranei ai suoi dati di addestramento, la rende uno strumento particolarmente utile e flessibile, secondo Ho. Oltre a calcolare altre forze, come l’idrodinamica, il team di Ho spera di riuscire a capire più approfonditamente come questo modello effettivamente funzioni. Ciò porterebbe benefici per l’avanzamento dell’intelligenza artificiale e del machine learning.

«Possiamo essere un parco giochi interessante per uno studente di machine learning, così che possa capire perché questo modello estrapola così bene i dati, perché estrapola gli elefanti invece di riconoscere solo cani e gatti. – ha detto Ho – È una strada a doppio senso tra la scienza e il deep learning.»

«Il nostro modello è sufficientemente generalistico da poter testare simulazioni con parametri cosmologici significativamente differenti dal set di dati di addestramento. Ciò suggerisce che il nostro modello di deep learning può potenzialmente essere implementato per una vasta gamma di simulazioni ben oltre lo spazio parametrico coperto dai dati di addestramento.» dicono i ricercatori.

Continua a leggere le notizie di Mediagold, segui la nostra pagina Facebook e X, resta aggiornato con le nostre ultime notizie da Google News.